既に掲載した、【2024年 地政学動向】2024年に予想される地政学的動向トップ10 (EY Japan) に続けて、テクノロジーのリスク、懸念ポイントの情報に接したので、取り上げてみたい。▼▼

「コントロールの喪失」の恐れがあるとしてGPT-4を超えるAIの即時開発停止を全技術者に対して6カ月間求める公開書簡、イーロン・マスクやスティーブ・ウォズニアックなど1300人以上が署名 出所 - GIGAZINE

「コントロールの喪失」の恐れがあるとしてGPT-4を超えるAIの即時開発停止を全技術者に対して6カ月間求める公開書簡、イーロン・マスクやスティーブ・ウォズニアックなど1300人以上が署名 - GIGAZINE

▼一部を抜粋し引用しておく

AIの研究課題や倫理などを含むガイドラインであるアシロマの原則を提示し

「アシロマの原則で述べられているように、高度なAIは地球上の生命の歴史に大きな変化をもたらす可能性があり、相応の注意とリソースで計画および管理する必要があります」

と述べ残念ながら、現状のAI開発はこのレベルでの計画や管理が行われていません。

* アシロマの原則 これなら知ってる👇

https://www.tmresearch.co.jp/sensor/pdf/sensor035.pdf

Ai 開発の6原則は?

Microsoft では、責任ある AI における 6 つの基本原則として、アカウンタビリティ、包括性、信頼性と安全性、公平性、透明性、プライバシーとセキュリティを挙げています。 これらの原則は、AI が主流な製品やサービスに活用されていく中で、責任があり、信頼できる AI を生み出すために不可欠です。2023/08/03

Ai 8原則とは何ですか?

- 「個人のプライバシー」

- 「説明責任」

- 「安全性とセキュリティー(第三者からの侵害)」

- 「透明性と説明可能性」

- 「公平性と無差別」

- 「人間による制御」

- 「専門家の責任」

- 「人間の価値の促進」――である。

詳細はわからないけれど、今現在でも「AI原則」で検索をすると、6,7,8 と数の異なる原則が検索結果で表示される。ということはつまり統一的な管理のための原則はまだ存在していなく、いくつかの "案" が併立する状態だということなのだろう。

テクノロジーの法則はともかくとして、活用や制御など、使う際のヒトがAIやAI機能を搭載した形としてのロボット類を安全で平和に管理するための概念や法則は未定で未確定。そんな未知の部分を多く含んでいるような思えるのが今の時点の生成AIなんだろうか。最先端のイノベーティブな技術の領域には、さまざまな基本知識と理解・認知を要するということか…。

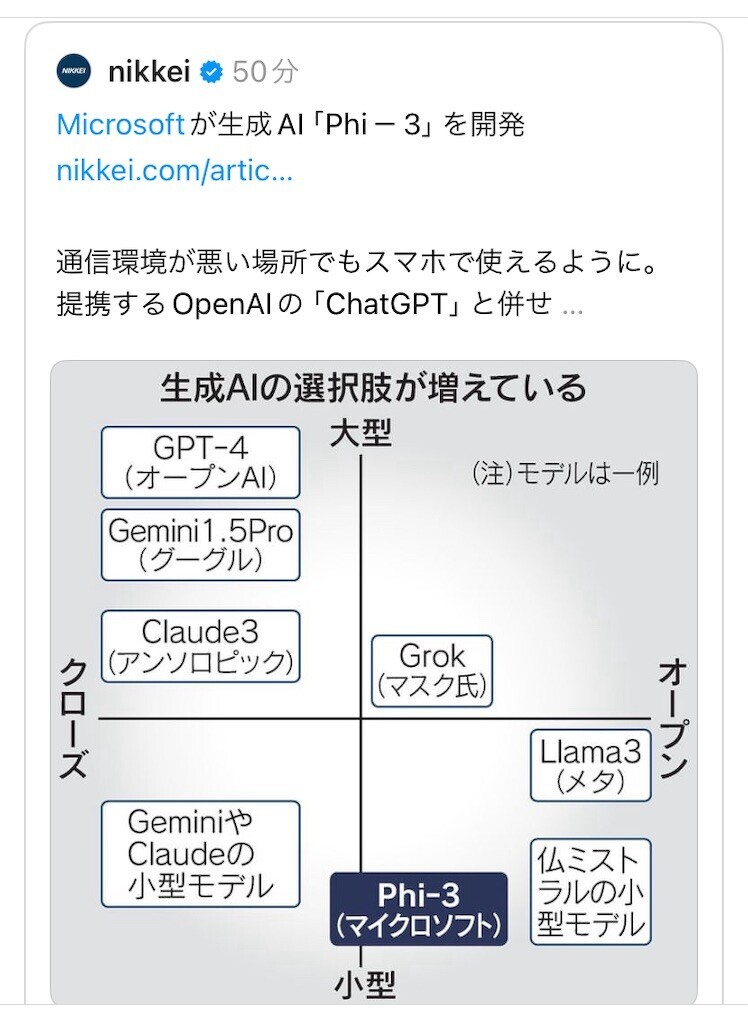

【関連情報】出所 : Threads 投稿の日本経済新聞から👇「生成AIの選択肢が増えている」

同種同類、つまりは競合が開発されすぐさまマーケットインしてくる。この手の比較知識を常にアップデートして、さらに俯瞰できるよう頭に入れておかないと実際の仕事の会話についていけない

▶︎というのが(以前の)勤め先でのプレッシャーでもあった。知識を溜めていくことは面白く、そしてためになるところでもある。頭の体操になるので、仕事は異なるが今でも継続的🎯にフォローしている。これもひとつの 趣味ですね。

👇こういう使い方提案もある。なかなかいい。

NEC、社内サーバーで生成AI 機密情報を社外に出さず【イブニングスクープ】 - 日本経済新聞

NEC、社内サーバーで生成AI 機密情報を社外に出さず 【イブニングスクープ】 - 日本経済新聞

これなら仮に暴走しそうになろうとも、あらかじめなんらかの強固な手立てを施しておき、社外にAIが勝手にデータ漏れを起こさぬようにする。AI用のセキュリティを施しておくことができるのでは?

意図せぬ勝手な自立行動を始めた場合、シャットダウンではなく、バラバラに解体してしまうフェイルセーフなんて、できればいい。

- 特に下記の新たな取り組みは、まさに『 記事の要約機能などで』fakeやよからぬ目的にデータ改竄して悪用などされぬよう、しっかりとセキュリティ・コントロールができていることが必須条件と思える。🔻

https://x.com/shibuya_nikkei/status/1782957754854093103?s=46

日本経済新聞社は24日、経済情報に特化した生成AIの基盤技術を開発したと発表しました。大規模言語モデルと呼ぶもので、約40年分の日経グループの新聞や雑誌の記事を学習させました。記事の要約機能などで活用を見込みます。モデルの名称は「NIKKEI Language Model」です。

出所 : @shibuya_nikkei at "X"